SD认识和web界面使用教程

新手如何认识Stable Diffusion

在2022年,Stable Diffusion(简称SD)模型的问世标志着AI行业从传统深度学习时代迈向了AIGC(人工智能生成内容)新时代的重要一步。SD模型在AI绘画领域扮演着核心角色,它能够将文字描述转化为图像(文生图),也能基于已有图像进行再创作(图生图)。与Midjourney不同,Stable Diffusion是一个完全开源的项目,这意味着它的模型、代码、训练数据和相关资源都可以免费获取和使用。

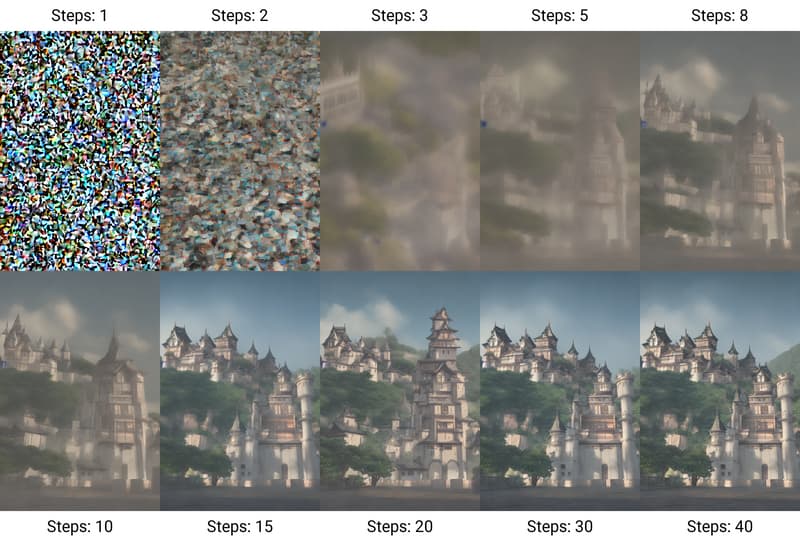

想象一下,使用Stable Diffusion就像玩一个创意游戏。你只需在界面上输入你想要的图像描述,AI就会根据这些描述,从它所学的海量图像和文字中寻找灵感,然后开始创作。这个过程可能需要一点时间,因为AI需要精心调整每一个细节,以确保最终的图像尽可能地符合你的想象。

Stable Diffusion的应用范围非常广泛,它在艺术创作、游戏设计、广告制作等领域都大放异彩。它不仅节省了人们的创作时间,还激发了无限的创意灵感。

对于普通人来说,学习使用Stable Diffusion有多重好处:

创意自由:无论你是艺术家、设计师还是创意爱好者,Stable Diffusion都能帮你将内心的想法转化为生动的图像,让你的创意不再受限于绘画技巧。

技能增值:掌握Stable Diffusion这样的AI工具,可以为你的技能库增添新成员,这在数字化时代对于个人和职业发展都是一大优势。

效率提升:如果你需要快速找到或创建图像,Stable Diffusion能帮你节省大量时间和成本,无需依赖外部资源。

教育与娱乐:教育工作者和家长可以利用Stable Diffusion激发孩子们的创造力,同时它也是一个有趣的互动工具,适用于教学和家庭娱乐。

商业节省:对于小企业和创业者,Stable Diffusion可以快速生成产品原型图和广告素材,无需聘请专业设计师,有效降低运营成本。

艺术探索:Stable Diffusion可以帮助你探索不同的艺术风格、色彩搭配和构图,提升你的艺术审美和设计能力。

社交互动:通过Stable Diffusion生成的图像可以在社交媒体上分享,增加你或你品牌的曝光度,吸引更多关注。

未来准备:随着AI技术的不断进步,掌握Stable Diffusion等AI工具的使用,将使你更好地适应未来的工作和娱乐趋势。

如何使用Stable Diffusion

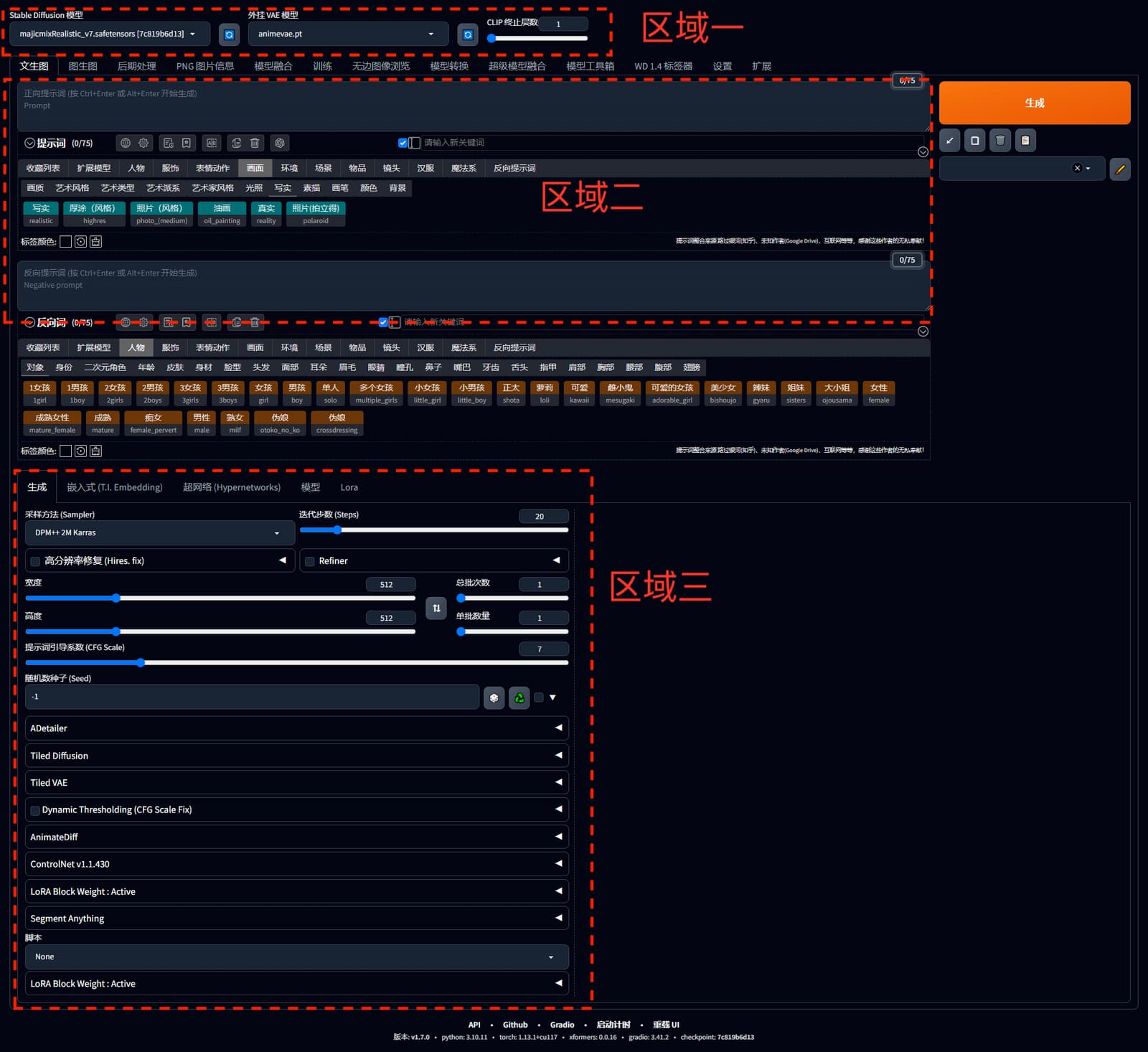

Stable Diffusion模型是算法科学家们研究的对象,我们作为用户,如何才能使用上这样一个AI模型呢?下面我就给大家介绍Stable Diffusion webUI工具,可以让我们轻松的通过图形化的界面来使用这些模型。

接下来我们来详细介绍各个区域的信息。

接下来我们来详细介绍各个区域的信息。

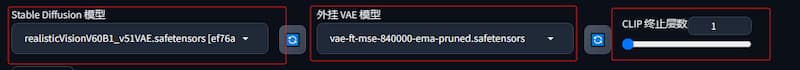

区域一:模型选择区域

Stable Diffusion模型:这里根据你想要生成图像的风格选用适合的模型,比如你是动漫风格就应该选择动漫模型,风景风格就应该选择风景类模型,模型可以去模型网站下载,或者留言给站长,站长分享链接。

外挂VAE模型:这是一种用于画面色彩增强的小模型,通俗解释就是图像生成好之后可以用后期处理给照片颜色处理。但是通常模型都已经包含相应的VAE模型,所以大部分情况下用处不大,针对必须要加VAE的模型,下载的时候通常也会特别说明。

CLIP 终止层数:设置为1为最后一层,模型默认12层最多,越往上细节越少。

举例说明:

1girl standing on a lake,early in the morning,beautiful sunshine,long black hair,cinematic,beautiful light,

(1女孩站在湖面上,清晨,美丽的阳光,黑色的长发,电影般的,美丽的光线)

层级设置的越高,丢失的细节越多,例子中主要提及6个细节,设置为1时所有细节都得到体现  当设置CLIP为6时得到的结果(可以看到只保留了女孩和清晨等提及的细节,其他部分丢失细节)

当设置CLIP为6时得到的结果(可以看到只保留了女孩和清晨等提及的细节,其他部分丢失细节)

区域二:提示词区域

功能选择:主要使用文生图 或者图生图,其他高阶功能在后续的视频中讲解

功能选择:主要使用文生图 或者图生图,其他高阶功能在后续的视频中讲解

正向提示词:用来输出你想要展示的图像提示词。

点击选择正向提示词:为英文基础较差的用户,提供了方便输入正向提示词的功能。

负向提示词:用于输入你不想他出现的内容。比如风景画中你不喜欢看到人类,这里输入人类,就可以达到控图的目的

点击选择负向提示词:为英文基础较差的用户,提供了方便输入负向提示词的功能。

区域三:插件区域

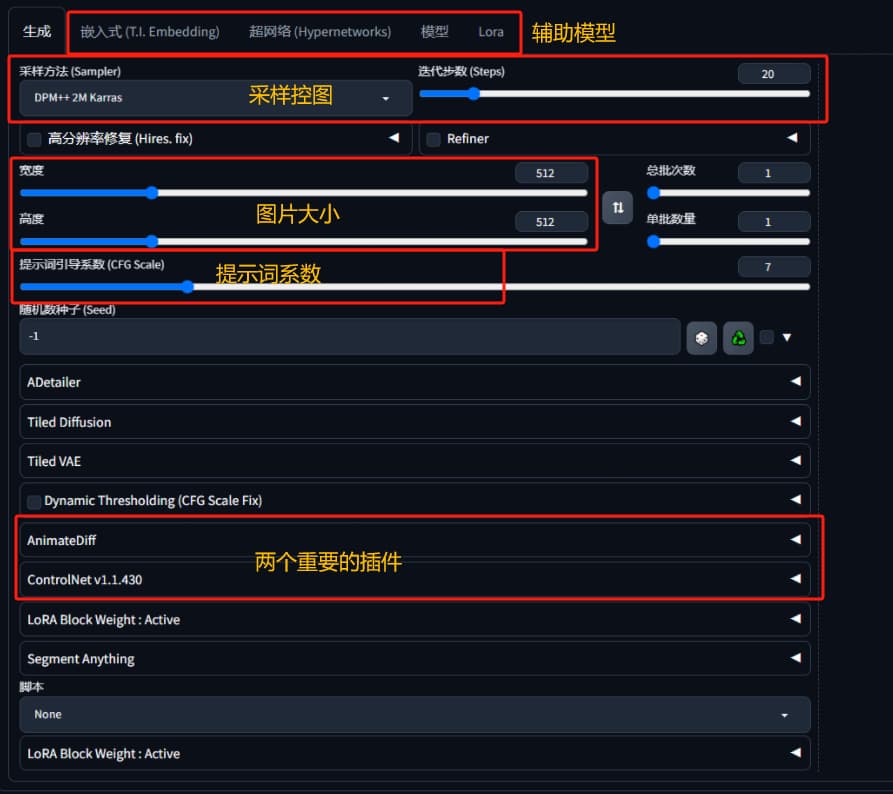

辅助模型种类:

辅助模型种类:

Embedding :一种记录角色特征的小模型,比如柯南,奥特曼等具有特征的角色

Hyperworks:已经不适用,可以忽略

Lora:也是一种记录特征的小模型,比Embedding大,记录的特征更多,可以根据提示词生成一系列相近角色图片,常用于固定模特不同姿势换装展示。

采样方法:

选择不同的采样器,可以使生成角色的细腻程度不同,大家使用上可以简单归类。

如果我们比较关注图片质量,那最好选择带 DPM++、Karras、2M或者3M的,比如:DPM++ 2M Karras、DPM++ 3M SDE Karras、DPM++ 2M SDE Heun Karras、DPM++ SDE Karras ;或者使用较新的 UniPC。

如果想要快速或者简单的图像,Euler、DDIM是不错的选择。

懒人就直接选择UniPC,测试在不同模型下效果都很稳定。

迭代步数:

20-30之间,虽然很多教程跟你说越大图片越精细,但是同样出现问题,比如人物多个手,天上多个太阳,都是因为过度迭代导致的。

图片宽度高度:

根据自己的显卡显存决定,越大可以越细,如果使用过程看到OutOfMemory等字样的错误信息,请调小宽高。

提示词引导系数:

SD是一个有创造力的程序,一副照片的构成,一部分使你输入的,一部分是他自己构想出来的,那么多少用你的意思,多少比例用他自己的构思,就是这个值决定的。

1–大多忽略你的提示。

3–更有创意。

7–遵循提示和自由之间的良好平衡。

15–更加遵守提示,图片的对比度和饱和度增加。

30–严格按照提示操作,但图像的颜色会过饱和。

这里特意留空两个插件

AnimateDiff : 将图片转成动画的插件

ControlNet: 精确控图的插件,固定动作,换脸,换衣服都是这个插件的能力

后续在我们创作,生成短视频内容时,发挥重要作用。

.png)